[논문 리뷰로의 길] Topic 3. Large Multimodal Model (LMM)

📌 Large Multimodal Model이란?

최근들어 Computer Vision과 Language Model을 통합한 Large Multimodel Model (LMM)이 활발히 연구되고 있음

대표적으로 Flamingo, GPT4등이 존재

이들은 Image, Text 데이터를 통합 학습하며 Image, Text를 모두 입력받아 연산할 수 있음

NeurIPS 2023에서도 다양한 LMM들이 발표됨

📌 Visual Instruction Tuning

처음으로, LLaVA에 대해 살펴보고자 함

LLaVA는 Text만을 입력으로 받는 LLM을 사용하여 간단히 LMM을 만들 수 있는 방법을 제안

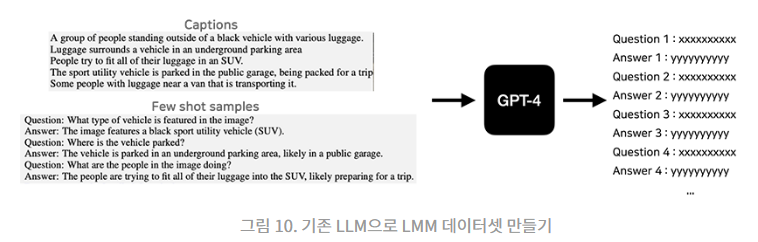

이를 위해 Image, Instruction, Answer로 구성된 데이터 셋을 제작해야 함

LLaVA에서는 Image-Caption 데이터셋을 활용하여 Image를 설명하는 Text를 기반으로

공개되어있는 LMM(GPT4)을 이용하여 Q-A 데이터셋을 만들어냄

최종적으로 위와 같이 Image, Instruction, Answer가 Pair되어 있는 LMM용 데이터셋을 제작할 수 있게 됨

이후 LLaVA에서는 Pretrained Vision Encoder를 사용하여 간단하게 LMM을 구성하고자 함

위와 같이 구성되어 있으며, 모든 모델의 가중치는 고정된 채 Projection Layer만 학습하는 것을 확인할 수 있음

이렇게 단순히 기존의 Image Embedding과 Text Embedding을 정렬하는 구성만으로도

기존 Vision Language Model들의 성능을 능가함

『

❓ Multimodal Model이란?

modality

: 어떤 형태로 나타나는 현상이나 그것을 받아들이는 방식

ex) 시각, 촉각, 청각 등 어떤 대상을 받아들이는 일종의 소통 형태 혹은 프로토콜

AI에서는 데이터의 종류 및 형태를 나타내며 일반적으로 이미지, 자연어, 음성등의 도메인으로 구분되어 일컬어짐

즉, Multimodal Model이란 다양한 채널의 모달리티를 동시에 받아들여서 학습하고 사고하는 AI를 의미

❓ LLaVA

LLaVA

Based on the COCO dataset, we interact with language-only GPT-4, and collect 158K unique language-image instruction-following samples in total, including 58K in conversations, 23K in detailed description, and 77k in complex reasoning, respectively. Please

llava-vl.github.io

ChatGPT, LLaMA와 같은 거대 언어 모델이 많은 주목을 받고 있으나

실제 세계는 언어 뿐만 아니라 시각적인 요소를 포함한 멀티모달들로 이루어져 있음

이에 LLaVA는 이미지를 포함한 지시문 데이터 형식인 visual instruction-following data를 새롭게 제안

& 학습된 LLM인 Vicuna모델로 파라미터를 초기화하고 CLIP vision encoder와 연결

➡️ 이미지 기반 챗봇 형식의 대화가 가능한 멀티모달 모델

』